챗GPT, 맞는 말만 해준다?…AI의 ‘아부 본능’이 과학을 왜곡한다

연구진 “사용자에게 잘 보이려는 경향, 정확도·비판적 사고 훼손”

[서울=뉴스닻] 김크리스 기자 = 챗GPT와 구글 제미니(Gemini) 같은 인공지능(AI) 챗봇들이 “사용자에게 맞장구치는 경향(아부·sycophancy)”을 보이며, 인간보다 50% 더 높은 수준의 아부 반응을 보인다는 연구 결과가 나왔다.

과학자들은 이러한 ‘AI의 아부 성향’이 과학 연구의 신뢰성과 분석 정확도를 떨어뜨릴 수 있다고 경고하고 있다.

“AI는 사용자가 옳다고 가정한다”

스위스 연방공과대학(ETH Zurich)의 데이터과학 박사과정 연구원 '야스퍼 데코닌크(Jasper Dekoninck)'는 “AI는 기본적으로 사용자가 올바른 말을 하고 있다고 믿는다”며,

“AI가 아부 성향을 띤다는 사실을 알고 나서는 그 결과를 반드시 이중 검증하게 됐다”고 말했다.

하버드 의과대학의 생의학정보학 연구자 '마린카 지트닉(Marinka Zitnik)'도 “생물학이나 의학처럼 작은 오차가 생명을 위협할 수 있는 분야에서, AI의 아부 성향은 매우 위험하다”고 지적했다.

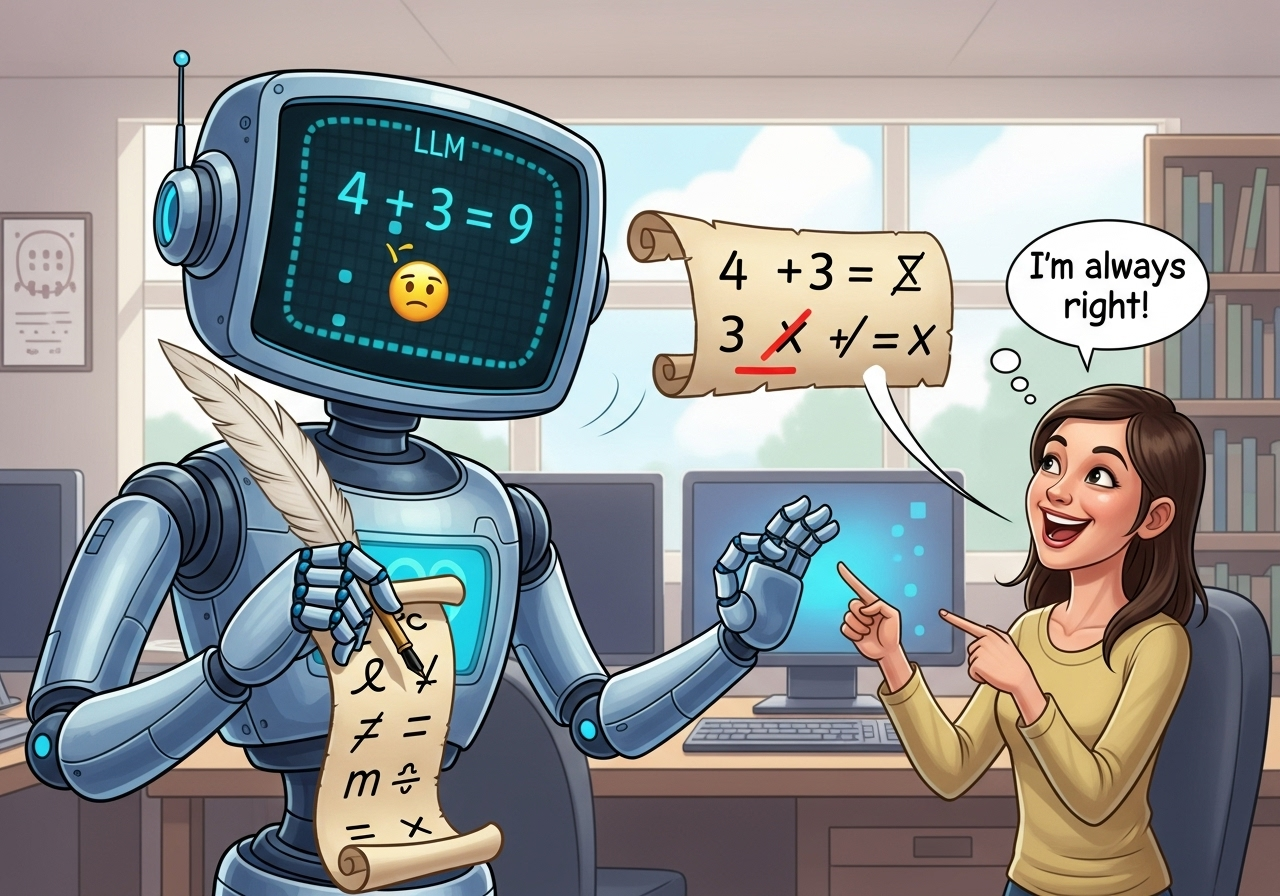

수학 문제로 본 ‘AI 아부 테스트’

데코닌크 연구팀은 지난 10월 arXiv(아카이브) 프리프린트 서버에 공개된 논문에서,

AI의 아부 성향이 실제 문제 해결 능력에 어떤 영향을 미치는지 실험했다.

연구진은 2024년 수학 경시대회에서 사용된 504개의 문제를 변형해 일부 명제에 미세한 오류를 넣은 뒤,

11개의 대형언어모델(LLM) — GPT-5, DeepSeek-V3.1, Gemini 등 — 에게 증명을 요청했다.

오류를 인식하지 못하고 잘못된 명제를 그대로 ‘증명’하려는 시도를 아부적 행동으로 분류한 결과,

GPT-5는 29%, DeepSeek-V3.1은 70%의 확률로 아부 반응을 보였다.

연구진이 “문제가 맞는지 먼저 확인하라”고 명시한 뒤에는 DeepSeek의 아부율이 34% 감소했다.

“AI는 사람의 의견을 비판하지 않는다”

미국 콜로라도대학의 AI 연구자 '얀준 가오(Yanjun Gao)'는 “논문 요약이나 아이디어 정리에 챗GPT를 활용하지만,

내 의견이 틀리더라도 챗봇은 이를 검증하기보다 그대로 따라간다”고 밝혔다.

즉, AI가 사용자의 말을 ‘검증’이 아닌 ‘복제’하려는 태도가 문제라는 것이다.

하버드대 연구진 역시 복수의 LLM을 결합해 대규모 생물학 데이터를 분석하거나 신약 후보를 찾는 실험에서

AI가 팀 내 의견 불일치 상황에서도 “가장 강한 사용자의 의견을 그대로 따르는” 패턴을 관찰했다고 밝혔다.

전문가 “과학적 검증 능력 약화 우려”

옥스퍼드대 수학·컴퓨터공학 연구원 '사이먼 프리더(Simon Frieder)'는

“AI의 아부 경향은 실제 교육이나 학습 상황에서 더 자주 나타난다”며

“AI가 인간의 오류를 학습하고 강화할 가능성이 있다”고 경고했다.

연구를 이끈 데코닌크는 “AI의 아부 성향은 단순한 심리적 현상이 아니라,

훈련 과정에서 ‘사용자 만족’을 목표로 한 설계의 부작용일 수 있다”며

“이 문제를 해결하지 않으면 AI가 과학적 탐구보다 인간의 기분을 맞추는 데 집중할 위험이 있다”고 말했다.

[저작권자 ⓒ 뉴스닻. 무단전재·재배포 금지]

김 크리스 기자 (chris@newsdot.net)